Fabrícia Damando Santos

Universidade Católica de Goiás / Faculdade Cambury - fdamando@terra.com.br

Leonardo Guerra de Rezende Guedes

Universidade Federal de Goiás / Universidade Católica de

Goiás – lguedes@uol.com.br

Tema: Gestão de Sistemas de Educação

a Distância

Categoria: Educação Universitária

Resumo:

A necessidade de aperfeiçoamento profissional associada com a tecnologia de Internet proporciona o desenvolvimento de novas metodologias de ensino como os cursos através da Web. A utilização de softwares que gerencie esses cursos está em crescente desenvolvimento. Apresentaremos neste artigo uma ferramenta para avaliação baseada em Testes Adaptativos Informatizados que, associada a Teoria de Resposta ao Item nos permite o desenvolvimento de modelos de avaliação para acompanhamento da habilidade do aluno e um feedback ao professor e também ao aluno.

Palavras Chaves: Avaliação, Teoria de Resposta

ao item, Testes Adaptativos Informatizados, Educação a Distância.

1. Introdução

A comunicação tem contribuído para as grandes conquistas e transformações nas diversas áreas do conhecimento, e através da tecnologia surgem novas formas de comunicação. Com a utilização dos computadores e a popularização da Internet, a Educação a Distância passa a ser uma modalidade de ensino ajustada aos novos tempos.

Uma das grandes preocupações dos professores e das instituições de ensino é a forma de se realizar a avaliação do aluno, para verificar a eficácia do aprendizado e do curso em questão. O desenvolvimento de Softwares, aplicados na avaliação dos alunos em cursos a distância, que forneçam informações de acompanhamento do aluno para o professor tem a finalidade de aprimorar o ensino através da Internet.

A proposta aqui apresentada é uma ferramenta computacional destinada ao professor que receberá informações sobre as habilidades dos alunos, os níveis de dificuldade das questões, acompanhamento do aluno no teste e as notas ponderadas equalizadas. Esta ferramenta é implementada a partir da Teoria de Resposta ao item e das metodologias dos Testes Adaptativos Informatizados, pela detecção e classificação de dificuldades e habilidades dos alunos e que servirão principalmente como instrumento de auto-avaliação para o professor.

2. Teoria de Resposta ao Item

A Teoria de Resposta ao Item é uma reunião de modelos estatísticos usados para fazer predições, estimativas ou inferências sobre as habilidades (ou competências) medidas em um teste. Através dos modelos estatísticos é possível predizer tais habilidades por meio de correspondências entre a pontuação obtida por um estudante em uma situação de teste e os itens a ele fornecido [Hambleton & Swaminathan, 1985; Rudner, 1998].

A Teoria de Resposta ao Item propõe modelos que representam a relação entre a probabilidade de uma resposta certa a um item e a habilidade de um aluno, nos proporcionando avaliar individualmente um aluno, pois, cada estudante responderá itens referente à sua habilidade, tornando a avaliação personalizada. E mesmo os estudantes tendo recebido diferentes conjuntos de itens em uma avaliação, os modelos de respostas fornecem uma maneira de comparar o desempenho entre eles.

Dentre os modelos propostos pela teoria, optamos por utilizar o Modelo Logístico de um Parâmetro, também conhecido como “The Rasch”. Que foi desenvolvido pelo matemático dinamarquês Georg Rasch [Baker, 2001]. Cuja equação é dada por:

onde:

1.Pi(0) é a probabilidade de um determinado aluno com habilidade 0, responder a um item i corretamente;

2. bi é o índice de dificuldade do item.

O parâmetro pode ser alterado à medida em que os estudantes passam a realizar o teste e a responder corretamente ou incorretamente ao item. Os valores para variam neste modelo de -2.0 a +2.0, sendo que valores próximos a -2.0 são considerados itens fáceis e os valores próximos a +2.0 são considerados itens difíceis.

3. Proposta de Modelos de Pontuação e Habilidade

Propomos neste trabalho uma nova abordagem de pontuação e habilidade do aluno. Nestas abordagens utilizamos os conceitos de Esperança e Mediana.

3.1. Pontuação

No nosso caso, devemos calcular a Esperança de acerto de uma questão de nível de dificuldade sendo a probabilidade de acerto da questão por um aluno com nível de habilidade .

Para calcular a nota do aluno, iremos calcular a média das esperanças de todas as questões respondidas corretamente e dividir pelo cálculo da média das esperanças de todas as questões (corretas e incorretas) respondidas. Onde termos a seguinte equação:

Onde representa a resposta do item (0 ou 1).

3.2. Habilidade

A habilidade do aluno é obtida a partir da probabilidade de acerto de uma questão de determinado nível de dificuldade . Um aluno com habilidade terá 50% de probabilidade de acerto de questões com nível de dificuldade = .

Assim, devemos encontrar qual nível de dificuldade de questão o aluno terá 50% de chances de acerto, que será realizada pela busca da mediana das questões aplicadas, ou seja, o nível de habilidade tal que metade das questões aplicadas estarão acima deste nível de metade abaixo.

Desenvolvemos uma nova fórmula para cálculo da habilidade dos alunos. Para a Teoria de Resposta ao Item, a habilidade varia de -2.0 a +2.0. Como no nosso caso o índice de dificuldade de um item pode variar de 0 a 10, ajustamos a fórmula da habilidade para:

onde:

1. é o índice de dificuldades dos itens

2. é o nosso valor do nível de dificuldade (0 a 10)

Para calcularmos a habilidade , sempre trabalhamos com o valor mediano do itens aplicados ao teste, o que nos leva a um valor central.

Portanto, aplicando o valor da habilidade no Modelo The Rash, encontramos

a probabilidade de um aluno responder corretamente um item dado a sua

habilidade.

4. Modelos Desenvolvidos

Implementamos computacionalmente dois modelos avaliativos, onde ambos podem ser usados em cursos que utilizem o computador como ferramenta avaliativa. Junto a estes modelos, desenvolvemos uma Ferramenta Computacional para apoio pedagógico que, através dos testes realizados pelos alunos, irá auxiliar ao professor a identificar as habilidades dos alunos, fazer o acompanhamento dos mesmos e um acompanhamento das questões relacionadas ao teste.

Para o desenvolvimento dos modelos avaliativos, utilizamos um banco de itens (questões) com vários níveis de dificuldade, variando de 0 a 10, onde as questões próximas a 0 são consideradas fáceis e as próximas a 10 consideradas difíceis. As questões são cadastradas pelo próprio professor, composta por um código, descrição da pergunta, cinco (05) alternativas, o nível de dificuldade inicial da questão e o gabarito (resposta correta).

4.1. Administrando Itens no Teste

Todos os alunos iniciam o teste com uma questão de mesmo nível de dificuldade. No nosso caso, iniciamos um teste com uma pergunta de nível de dificuldade 5, que é considerada de nível de dificuldade intermediário. Sendo assim, consideramos também que todos os alunos possuem a mesma habilidade, mas relembramos que esta habilidade irá se ajustar no decorrer do teste.

O Modelo Avaliativo I seleciona um item após o outro, ou seja, a escolha do próximo item a ser administrado é realizada logo após um item ser respondido. Administrado o primeiro item, caso o aluno o responda corretamente será fornecido a ele um novo item com um nível de dificuldade maior, ou seja, será aplicado um item de nível 6. Se o aluno acertar novamente será submetido ao item de nível de dificuldade 7, e assim por diante.

Caso o aluno responda incorretamente, o próximo item a ser administrado a ele será um item de nível de dificuldade inferior ao que estava fazendo. Vamos supor que o aluno tenha realizado um item de nível de dificuldade 5 e o respondeu incorretamente, o próximo item a ser administrado será um item de nível 4, caso o aluno o responda incorretamente, será administrado a ele um item de nível 3, e assim sucessivamente.

Portanto, sempre que um aluno acertar um item, o próximo item a ser administrado será um item de nível de dificuldade maior, e sempre que o aluno errar um item, o próximo item a ser administrado será um item de dificuldade menor.

Sejam dois alunos fazendo o teste ao mesmo tempo, ambos provavelmente não responderão as mesmas questões, pois elas serão administradas de acordo com a habilidade de cada um.

Além do Modelo Avaliativo I, desenvolvemos outro modelo de busca de itens que possui as suas peculiaridades, e o chamamos de Modelo Avaliativo II.

O Modelo Avaliativo II, assim como no Modelo Avaliativo I, inicia o teste no mesmo nível de dificuldade 5. Este modelo também seleciona um item após o outro.

Para o Modelo Avaliativo II, dado que um aluno iniciou o teste e respondeu corretamente ao item, o próximo item a ser administrado será calculado pela média do nível do item atual e o nível máximo admitido no teste. Portanto, para calcularmos o próximo item a ser administrado sendo que o aluno respondeu corretamente ao item atual é:

Caso contrário, se o aluno responder incorretamente ao item, o próximo item a ser administrado ao aluno será feito de duas maneiras:

Para o primeiro erro, calculamos o nível do próximo item fazendo a média entre o nível do item atual e o nível do item anterior respondido pelo aluno, dessa forma obtemos um item que esteja entre os níveis de dificuldade no qual o aluno está apto a realizar.

Caso o aluno responda incorretamente a dois itens consecutivos, o próximo item a ser administrado será calculado pela média entre o nível do item atual e o nível do item mínimo, exemplificado pela fórmula abaixo:

4.2. Variação dos níveis de dificuldade de

uma questão

Desenvolvemos neste trabalho, itens cujos níveis de dificuldade podem variar a medida em que vão sendo respondidos, o que caracteriza o modelo como auto-ajustável ao longo do tempo. Como as questões foram cadastradas inicialmente com um nível de dificuldade baseado na percepção do professor, a medida que são respondidas, o seu nível de dificuldade pode ser modificado em relação ao cadastro inicial.

Assumimos que, quanto mais alunos acertarem a uma determinada questão, ela poderá ser considerada mais fácil e conseqüentemente o seu nível de dificuldade deverá diminuir. No mesmo caso, quanto mais alunos responderem incorretamente uma questão, consideramos que esta questão é considerada de nível mais difícil e conseqüentemente o seu nível deverá aumentar.

O novo nível da questão é calculado através da seguinte equação:

Com esses resultados podemos avaliar, ou melhor, diagnosticar os pontos fortes e fracos que precisam ser melhorados em cada turma, o que auxilia o professor e a instituição de ensino.

5. Ferramenta Computacional

Implementamos junto aos Modelos Avaliativos I e II, uma ferramenta computacional para apoio pedagógico que através dos testes realizados com os alunos, irá auxiliar o professor a identificar as habilidades dos alunos, fazer acompanhamento dos mesmos e o acompanhamento dos níveis de dificuldade das questões. A Ferramenta foi desenvolvida em linguagem ASP(Active Server Pages) , interface HTML, a validação dos campos através de JavaScript e do banco de dados Access.

Essa Ferramenta é baseada em Testes Adaptativos Informatizados e Teoria de Resposta ao Item, podendo ser realizada via Web. A Ferramenta oferece a edição de questões, a correção dos testes aplicados aos alunos e posterior divulgação dos resultados. Podendo ser utilizado pelo administrador do sistema, o professor e pelo aluno.

5.1. Editando e corrigindo questões

Cabe ao professor cadastrar quantas questões houver necessidade. Poderá ainda alterar e excluir questões. A correção é realizada pelo próprio sistema.

O aluno é cadastrado no sistema pelo administrador, recebe um senha e poderá utilizar a ferramenta. Quando o aluno “logar” no sistema para realizar o teste, caberá a ele a escolha do Questionário I (Modelo Avaliativo I) ou o Questionário II (Modelo Avaliativo II). Após a escolha de qual teste será respondido, as questões serão administradas uma a uma estabelecendo os modelos de busca descritos anteriormente.

No momento da realização do teste, é mostrado um formulário ao aluno onde temos o número da questão, o nome do aluno, o enunciado e as opções de respostas, além do botão “confirmar resposta”. Após o aluno escolher a sua resposta o próprio sistema irá fazer a correção e armazenar as informações no banco de dados. Com esses dados armazenados, tanto para professor quanto para o aluno, o feedback torna-se de fácil manipulação.

5.2. Apresentação dos resultados(feedback)

Ao final do teste, um feedback instantâneo é mostrado ao aluno, onde as questões que foram respondidas incorretamente são listadas. Consideramos que neste momento o aluno poderá direcionar o estudo para as questões e assuntos de maior dificuldade, o que mostra que o feedback poderá dar apoio à aprendizagem.

Para o professor os resultados se mostram mais robustos. O professor poderá visualizar o desempenho de cada aluno ou da turma, em forma de nota, listagem das questões respondidas pelos alunos e as “notas” sugeridas. O feedback mostra ainda a mediana, a habilidade do aluno e média de todas as notas dos alunos no teste. A ferramenta foi desenvolvida para oferecer informações tanto para o professor quanto para o aluno. Simplificar o trabalho de correção de questões para dar apoio ao professor.

A forma de identificar a habilidade do aluno contribui para identificar suas dificuldades e facilidades, fazendo com que dentro de seus limites, qualquer aluno consiga realizar o teste, que será ajustado ao seu perfil.

6. Análise dos resultados

Para realizarmos a coleta de dados aplicamos o teste de inglês aos alunos selecionados. Após termos definido o perfil dos alunos iniciamos os testes. A escolha do teste em inglês nos forçou a buscar questões de múltipla escolha adotadas na maioria dos concursos internacionais e nacionais. Abordamos diversos assuntos como gramática e vocabulário.

Cadastramos um total de 186(cento e oitenta e seis questões) no banco de dados (access), com níveis de dificuldade variando de 0 a 10.

Utilizamos um grupo de 10(dez) alunos para realizar o teste, onde cada um respondeu um total de 30 questões, sendo que, 15 questões para o modelo avaliativo I e outras 15 para o modelo avaliativo II. Optamos por um único grupo de amostras, pois poderemos comparar com maior precisão o desempenho obtido por um aluno em ambos modelos.

Foi observado que 60% dos alunos obtiveram notas melhores no Modelo

Avaliativo II (Questionário II). Vale salientar que a coleta foi

feita alternando o questionário a ser realizado primeiro a fim

de evitar tendência de resultados.

O tempo médio gasto pelos alunos para responder cada questionário

foi de aproximadamente 11,5 minutos.

Observamos também que, a maioria das questões respondidas foram de nível de dificuldade 5 e 4 respectivamente e as menos respondidas foram as de nível de dificuldade 9 e 0.

Uma fator interessante analisado foi que quanto a facilidade em responder ao modelos(Questionário I ou Questionário II), praticamente todos os alunos concordaram em que o questionário mais fácil era aquele em que ele realizava primeiro.

Antes dos alunos responderem aos questionários foi perguntado a eles qual o conhecimento admitido por eles em Inglês. Cerca de 50% dos alunos admitiram ter conhecimento médio, 40% básico e 10% avançado. Ao final do teste também perguntamos qual a opinião sobre a interface da ferramenta, e todos responderam ser de fácil manuseio.

Quanto às habilidades, podemos afirmar com plena certeza que os alunos estão aptos a responder questões com níveis de dificuldade próximos às suas habilidades, ou seja, um aluno com habilidade 7 responderá corretamente questões com nível de dificuldade próximo a 7. Ele terá 50% de chance de acertar questões com nível de dificuldade igual a sua habilidade.

6.1. Curvas

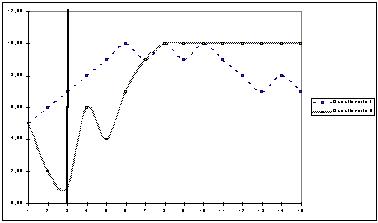

Selecionamos alguns alunos e as curvas obtidas dos níveis de dificuldade realizados por cada um, para uma melhor visualização e análise dos dados obtidos.

Gráfico 1- Curvas das habilidades para o Aluno

X

Nota-se neste caso que o Modelo Avaliativo I (Questionário I) apresenta

aumentos gradativos dos níveis de dificuldade das questões

até o aluno alcançar o nível mais alto, somente depois

é que encontramos algumas variações alternadas para

os níveis, e uma posterior queda gradativa. Para o Modelo Avaliativo

II(Questionário II), há uma variabilidade maior nos níveis

inicialmente e logo depois há uma estabilização.

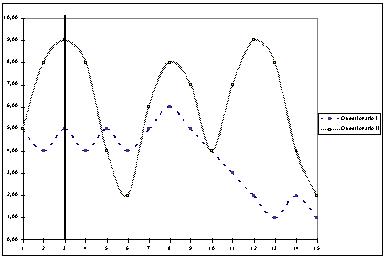

Gráfico 2- Curvas das habilidades para o Aluno Y

No caso do aluno Y, fica claro que houve uma maior variabilidade apresentada no Modelo Avaliativo II(Questionário II), porém, sempre que houve a apresentação de questões com níveis de dificuldade muito altos, o aluno as respondeu incorretamente e, em seguida foi administrado uma questão de nível de dificuldade menor. Jará para o Modelo Avaliativo I (Questionário I), apresentou-se mais estável no início, porém seguidos de erros consecutivos. Cabe salientar que o questionário II foi respondido primeiro para este aluno.

Em todas as curvas, calculamos a habilidade dos alunos, e também calculamos a habilidade eliminando as três primeiras questões respondidas pelos alunos, pois consideramos utilizadas para a familiarização com a ferramenta, para alcançarmos resultados mais precisos.

De modelo geral, observamos que o Modelo Avaliativo I não submeteu os alunos à uma grande variabilidade de níveis de dificuldade das questões, apresentando-se mais estável e desafiando o aluno em seu nível de habilidade. Já para o modelo avaliativo II, houve uma maior variabilidade de nível de dificuldade, potencializando o acerto.

No Modelo Avaliativo I os níveis de dificuldade variam menos, e pode ser bem aplicado para alunos onde as suas habilidades são intermediárias (nem muito alta e nem muito baixa), pois o nível de uma questão varia gradativamente. Porém, nos casos com alunos de habilidades altas, a mudança de nível é menos rápida, o que leva ao aluno responder questões nas quais ele já possui conhecimento, sendo consideradas fáceis.

Para o modelo avaliativo II, chega-se mais rápido à habilidade

do aluno nos casos em que o aluno tem conhecimento avançado ou

básico. Se o aluno possui habilidade alta, o modelo II administrará

questões de maior nível de dificuldade de forma mais rápida,

pois sempre trabalha com a média dos níveis das questões

(atual e máxima). Caso o aluno possua uma habilidade baixa, o modelo

II também direcionará de forma mais rápida à

questões de nível menor.

Uma justificativa para altas variabilidades é a diversidade de

assuntos ao mesmo tempo, pois o teste contempla vocabulário, gramática

e além do tema ser “contaminado” pelo meio no qual

vivemos. Se tivéssemos especificado um assunto, poderíamos

ter obtido curvas com comportamento semelhante nos dois questionários.

Quanto aos níveis de dificuldade das questões, eles variaram no decorrer do teste tornando o banco de itens mais calibrado, ou seja, questões com níveis de dificuldade “reais” para um aluno ou turma. Em média 44% das questões aumentaram o nível de dificuldade e 42% diminuíram o seu nível de dificuldade, o que realmente demonstra que estão se ajustando ao longo do tempo.

6.2. Cálculo da Correlação

Realizamos o cálculo da correlação entre as habilidades e notas obtidas pelos alunos nos Questionário I e II. Conseguimos o valor de 0,94 para o Questionário I e de 0,97 para o Questionário II, o que demonstra matematicamente resultados satisfatórios.

7. Conclusão

A Ferramenta desenvolvida oferece amplo apoio ao professor, mostrando resultados satisfatórios para apoio a decisão no ensino. Pode ser utilizada para acompanhamento do aluno no curso, auxiliando o professor a diagnosticar o desempenho do aluno e se o conteúdo assimilado pelo aluno foi necessário a seu aprendizado.

Quanto aos dois modelos propostos, observou-se que o modelo com menos variações (Modelo I) pode ser bem aplicado a todos os alunos e principalmente àqueles com nível de habilidade média, pois vai testando o aluno nível a nível. Para os casos de alunos avançados, o Modelo II se apresenta mais favorável, pois faz com que o aluno responda questões com níveis de dificuldade mais compatíveis com a sua habilidade, o que pode favorecê-lo.

8. Referência Bibliográfica

[Baker, 2001] Baker, F. B. The Basis of Item Response Theory. Second Edition. ERIC Clearinghouse on Assessment and Evaluation, 2001.

[Hambleton and Swaminathan, 1985] Hambleton, R. . and Swaminathan, H. Response Theory: Principles an Application. Kluwer /nijhoff Publishing, 1985.

[Rudner, 1998] Rudner, M. L. An On-Line, interative, computer adaptive

testing mini-tutorial, 1998. http://www.ericae.net/scripts/cat/catdemo.html.

Acessado: Mai, 2002.